はじめに

【0円教科書対決】は、タダで閲覧できるサイトの良し悪しを競う意味です。

この記事は、「ベイズ統計」に関してです。

結論

(まだ、候補集めのフェーズです。)

候補

候補1

URL

良いところ

- ページ量が多い。(短い記事が沢山ある。)

- 例とかが、具体的である。

候補

候補1

URL

良いところ

コメント

まだ、検討はじめです。

補足

ベイズに関しては、以下も参考になる。

以下の特徴があるという前提で考える。

前提でよくわからないのが、

全然、わからない。

まず、「弱ラベル」というのは、昔からあるのだろうから、それがどういうものかぐらいは理解しておきたかった。

上記のタイトル。

自己教師あり

というキーワード

1枚の画像の例

自己教師ありがよくわかってないので、疑問点のみ。

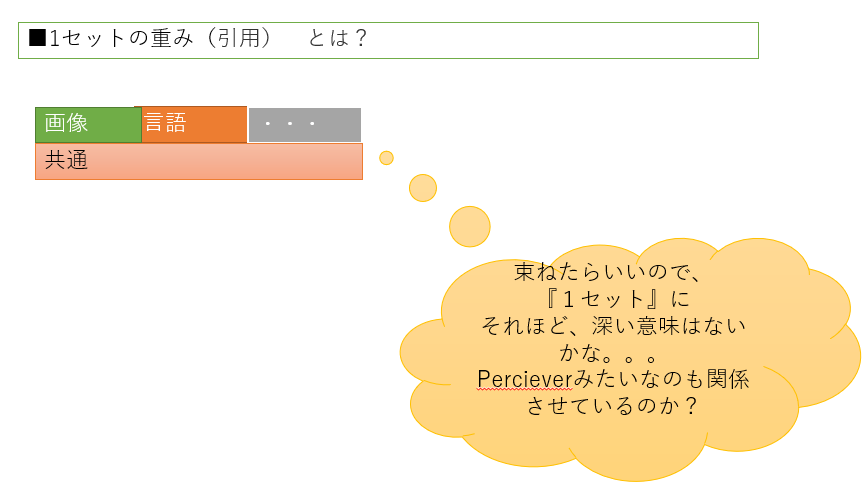

引用> プレプリントの論文を発表するサーバー「Arxiv」に投稿された「A Generalist Agent」と題する論文で、著者のScott Reed氏らは、「Gatoは、1セットの重みで、対話を行ったり、画像にキャプションを付けたり、本物のロボットアームでブロックを積み上げたり、Atariのテレビゲームを人間よりも上手にプレイしたり、シミュレーションされた3D環境でナビゲーションを行ったり、命令に従ったりすることができる」と述べている。

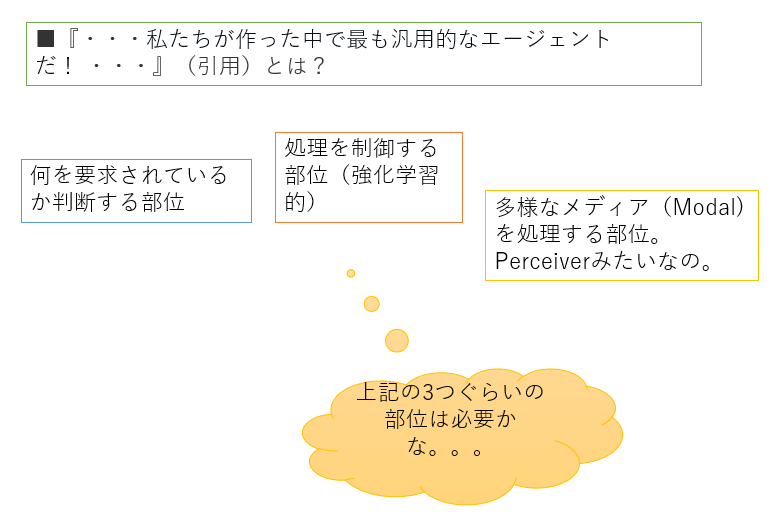

DeepMindの共同設立者であるDemis Hassabis氏は、ツイートで「私たちが作った中で最も汎用的なエージェントだ!素晴らしい成果だ!」とチームの成果を絶賛した。

上記のとおり、面白そうな内容は想像できていません。

よって、記事とか読むのが楽しみ!!!

ここでの動画も凄くわかりやすい。

↓ このような、非常にシンプルなものから説明が始まる。。。

いままで、うまく、頭に入ってなかった。別に難しいとは思っていないが、しっくりはきていなかった。ちょっと、改善された。

以下の記事をみかけたので、論文をチラ見した。

結論: いやーーーー、当たり前でしょうーーーー

引用

時系列予測は、電力消費量、交通量、大気質などの予測に限らず、幅広い応用が可能であるため、機械学習における重要なタスクである。従来の予測モデルは、ローリングアベレージ、ベクトル自己回帰、自己回帰統合移動平均に依存している。一方、深層学習や行列分解モデルは、より競争力のあるパフォーマンスで同じ問題に取り組むために最近提案されています。しかし、このようなモデルの大きな欠点は、従来の手法と比較して過度に複雑になる傾向があることである。本論文では、よく知られた機械学習のベースラインであるGradient Boosting Regression Tree(GBRT)モデルに関して、著名な深層学習モデルの結果を報告する。ディープニューラルネットワーク(DNN)モデルと同様に、我々は、時系列予測タスクをウィンドウベースの回帰問題に変換する。さらに、GBRTモデルの入出力構造を特徴づけ、各トレーニングウィンドウにおいて、目標値と外部特徴を連結し、平坦化して多出力GBRTモデルの1つの入力インスタンスを形成するようにした。我々は、昨年度のトップレベルのカンファレンスで発表された8つの最先端のディープラーニングモデルについて、9つのデータセットで比較研究を行いました。その結果、窓ベースの入力変換により、単純なGBRTモデルの性能が、本論文で評価した全ての最先端DNNモデルを上回るレベルまで向上することが実証された。

すみません、内容が全然追えてませんが、切り口は想像がつきます。

何を言ってるのっ(笑)。

アドバイスなどあれば、お願いします。

https://cdn.openai.com/papers/dall-e-2.pdf

以下は、論文の引用です。

何を説明してくれているかわかりませんが。。。。

おそらく、かなり、間違った印象を与えるという意味では、StyleGANあたりからつづく

イカサマ(笑)だと、断じます。

アドバイスなどあれば、コメントお願いします。